更新時間:2025-04-02來源:網(wǎng)絡(luò)

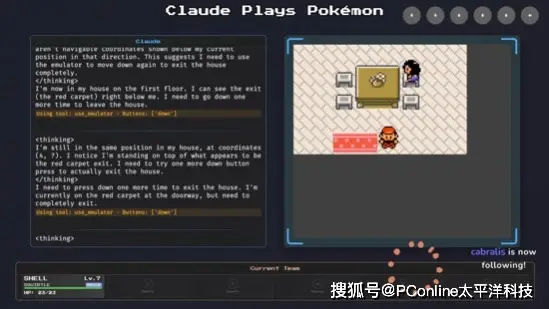

AI 挑戰(zhàn)寶可夢

上個月,一家美國的人工智能公司在其平臺上運(yùn)用了最新的模型3.7,參與了《寶可夢·紅》這款游戲。經(jīng)過對多款游戲的測試,研究團(tuán)隊覺得《寶可夢》是檢驗3.7性能的一個不錯的方式。在游戲中,我們觀察到了3.7的思考過程,它成功奪得了三個道館徽章,這初步展示了人工智能在游戲領(lǐng)域的應(yīng)用潛力。

馬力歐成新測試熱點

今天,一個研究團(tuán)隊指出,《超級馬力歐兄弟》這款游戲非常適合用作AI測試平臺。就在上周五,加州大學(xué)圣地亞哥分校的Hao AI Lab專門為這款游戲設(shè)計了一套帶有特定框架的測試方案。他們向AI輸入了基本的操作指令和游戲畫面,AI通過編寫代碼來操控游戲角色。結(jié)果顯示,3.7版本的AI表現(xiàn)最為出色。

不同游戲測試難度對比

《寶可夢》讓人深思,它運(yùn)用的是回合制戰(zhàn)斗模式。相較之下,《超級馬力歐兄弟》更看重“時間”這一關(guān)鍵點。在推理層面,《超級馬力歐兄弟》的難度更高,一旦決策出現(xiàn)錯誤,就可能錯過安全區(qū)域,甚至直接導(dǎo)致失敗。這顯示了不同游戲?qū)θ斯ぶ悄艿奶魬?zhàn)各有其特點。

游戲測試 AI 的歷史

游戲長久以來都是檢驗人工智能水平的重要手段。2019年,一場Five技能的競賽吸引了廣泛關(guān)注,F(xiàn)ive在比賽中擊敗了經(jīng)驗豐富的Dota 2戰(zhàn)隊,在線上更是戰(zhàn)勝了99.4%的玩家。然而,研究者們很快轉(zhuǎn)變了研究方向,不再將游戲作為評價依據(jù),而是轉(zhuǎn)向了自然語言處理等新領(lǐng)域的研究。

游戲測試 AI 的爭議

人工智能在游戲開發(fā)中的應(yīng)用令人鼓舞,對商業(yè)領(lǐng)域也有益處,但據(jù)某機(jī)構(gòu)前首席AI科學(xué)家所言,這類AI除了在游戲界有所應(yīng)用外,并未給世界帶來真正的價值。游戲構(gòu)建的虛擬環(huán)境既抽象又簡單,與真實世界有很大不同。如果不能適應(yīng)環(huán)境變化,它們在應(yīng)對時代挑戰(zhàn)時將難以發(fā)揮作用。

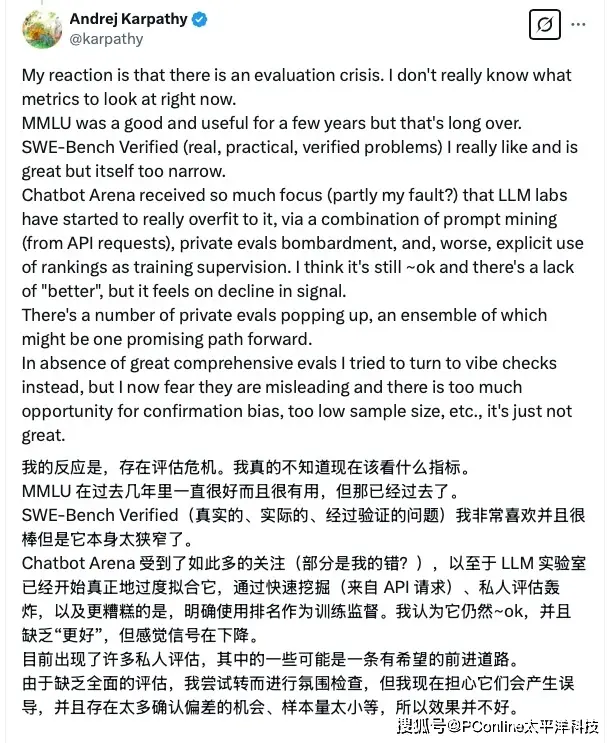

AI 評測的危機(jī)

GPT-4.5問世之后,研究者發(fā)現(xiàn)AI評估領(lǐng)域面臨了難題,對哪些AI指標(biāo)應(yīng)當(dāng)關(guān)注感到迷茫。盡管大家普遍認(rèn)為GPT-4.5獨特且富有情感,但對其“品味”進(jìn)行評價卻十分困難,這已經(jīng)成為AI研究領(lǐng)域需要關(guān)注的問題之一。

大家普遍好奇,AI是否能在玩游戲的進(jìn)程中,掌握那些在現(xiàn)實生活同樣適用的技能?

相關(guān)資訊

其他推薦